- Webcrawler

Webcrawler erklärt

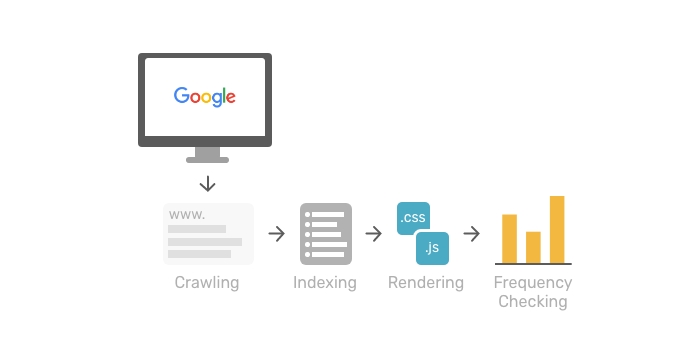

Ein Webcrawler, auch bekannt als Robot oder Bot, ist ein Computerprogramm, das vor allem von Suchmaschinen eingesetzt wird. Das Programm durchsucht automatisch das World Wide Web und analysiert alle gefundenen Webseiten.

Die Vorgehensweise eines Webcrawlers basiert dabei auf dem Aufsuchen aller auf den Seiten befindlichen Hyperlinks. Diese werden in eine Liste geschrieben und nacheinander besucht. Durch diese Methode könnten rein theoretisch alle erreichbaren Seiten des World Wide Web entdeckt werden.

In der Praxis wird jedoch meistens eine themspezifische Vorauswahl getroffen. Hier kommen so genannte focused crawlers zum Einsatz. Der Unterschied zu herkömmlichen Webcrawlern liegt darin, dass die themenspezifischen Webcrawler eine Art künstliche Intelligenz besitzen mit der sie den besten Weg durch das Web finden und dabei nur relevante Bereiche indizieren.

Trotzdem muss festgehalten werden, dass ein Großteil des Internets durch die Webcrawler und somit auch durch die Suchmaschinen nicht erfasst wird. Dies liegt daran, dass viele Seiten nicht über herkömmliche Hyperlinks, sondern nur über Suchmasken oder Portale erreichbar sind.

Ebenso kann ein Webdesigner durch ein zusätzliches Meta-Tag im HTML-Header und durch die Datei robots.txt dem Webcrawler verbieten Seiten zu indizieren. Ob dies jedoch von allen Webcrawlern auch eingehalten wird ist unsicher.

Einsatzbereiche:- Indexierung von Inhalten einer Webseite

- Untersuchung des Internets

- Sammeln von E-Mail Adressen (Spambots)

W